实验室的最新成果“Consistent Prototype Learning for Few-Shot Continual Relation Extraction”被ACL 2023收录为主会长文

发布时间:2023-07-17

国际顶级会议ACL2023近期公布了论文入选结果,实验室的最新成果“Consistent Prototype Learning for Few-Shot Continual Relation Extraction”被收录为主会长文(https://aclanthology.org/2023.acl-long.409/)。ACL全称国际计算语言学年会(Meeting of the Association for Computational Linguistics),是计算语言学和自然语言处理领域最重要的顶级国际会议,是中国计算机学会(CCF)推荐的A类国际学术会议。2021级硕士生陈修迪和2019级博士生武惠为论文的共同第一作者,史晓东教授为论文的通讯作者。

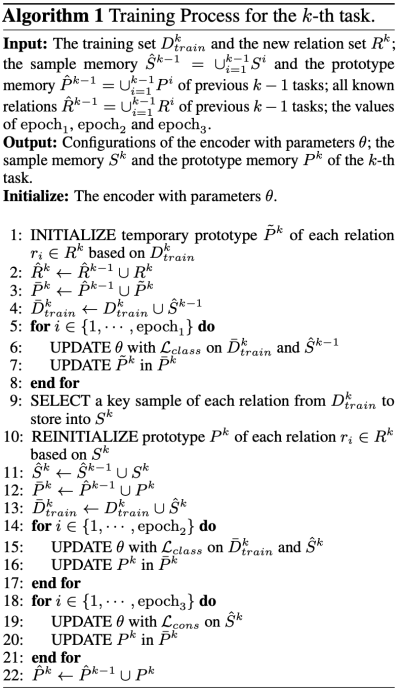

该论文提出了一个新的少样本持续关系抽取任务N-way-K-shot Continual Relation Extraction(NK-CRE),目的是不断训练递增的少样本数据,让模型在学习新关系的同时避免灾难性遗忘旧关系。针对此任务,论文提出Consistent Prototype Learning (ConPL)的方法来解决由于“对旧关系的不充分激活”以及“相似类别的混淆”所带来的灾难性遗忘问题,算法流程如图所示。具体地,论文提出多信息记忆模块来存储旧关系对应的关键样本和原型向量,并在训练中采用一致性学习损失函数不断地激活模型对于旧关系信息的记忆。此外,针对新旧关系太过相似而导致模型识别混淆问题,论文采用焦点损失来重点区分相似的关系类别。在两个常用数据集上的实验结果表明我们的方法显著优于现有的持续关系抽取方法。

该项研究获得了国家自然科学基金地方联合基金重点项目《人机协同翻译方法及关键技术研究》(项目编号: U1908216)的资助。