实验室2篇论文被ICASSP 2024接收

发布时间:2023-12-14

近日,人工智能国际会议ICASSP 2024公布录用结果,我实验室2篇论文被录用。AAAI会议全称为International Conference on Acoustics, Speech, & Signal Processing,是CCF-B类推荐会议。ICASSP 2024将于2024年4月14日至19日在韩国首尔举办。

研究主题包括语音翻译和手语翻译,录用论文的信息如下:

1. Memory-Augmented Speech-to-Text Translation with Multi-Scale Context Translation Strategy

作者:Yuxuan Yuan, Yue Zhou, Xiaodong Shi

本文由我实验室2021级硕士生元雨暄同学和2020级博士生周悦同学(共同一作),史晓东教授(通讯作者)共同完成。

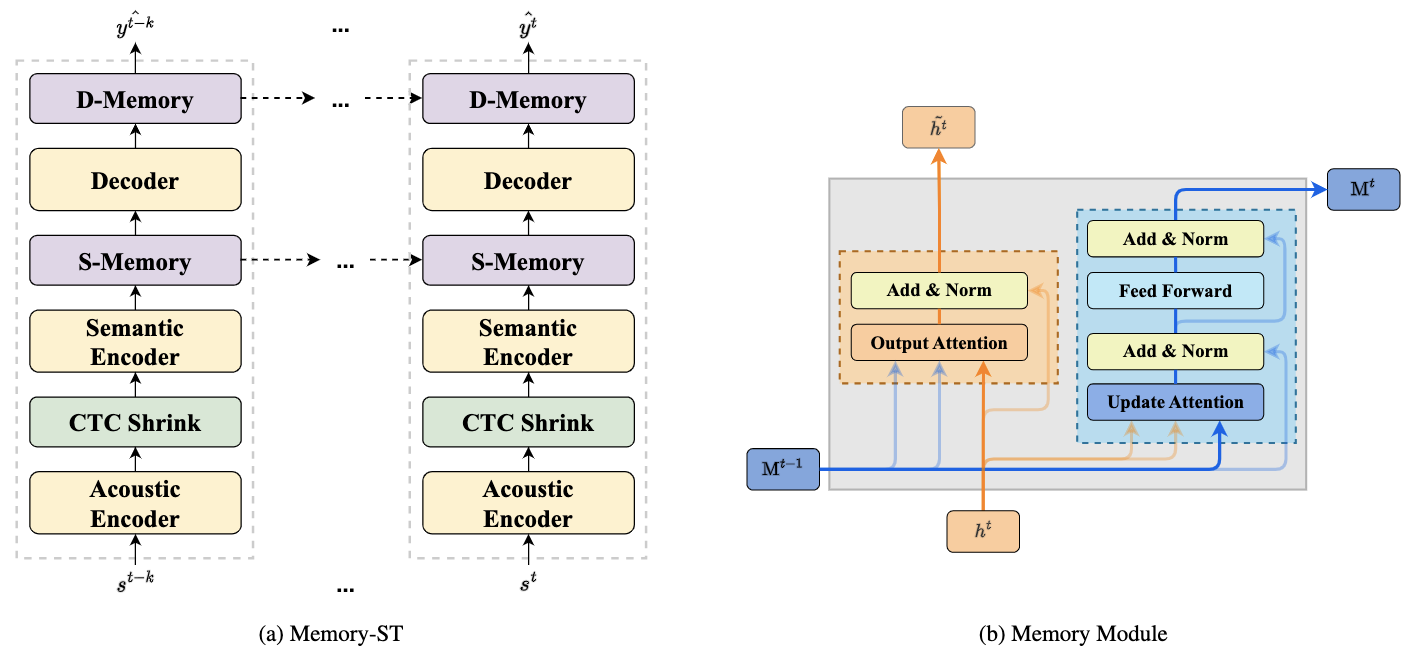

端到端的语音到文本翻译近年来引起广泛注意。现实场景下,音频通常较长并需要被分割成句子级片段以输入模型。句子级的语音翻译模型由于无法利用句间上下文信息而面临翻译质量不佳的挑战。在机器翻译领域中,上下文信息已被证明有助于解决句间语篇依赖性和提升文档级翻译质量。除了机器翻译中的语篇现象,语音翻译还存在了同音字和发音差异的问题。现有的上下文感知相关工作包括基于拼接音频的方式和基于额外编码器的方式,前者存在计算代价高、冗余信息多,后者存在忽略源端信息的问题。为解决以上问题,本文提出Memory-ST,引入Memory模块来存储并更新前文信息,将上下信息融入到当前隐藏表征以帮助翻译。为提升Memory模块提取句子语义信息的能力,本文提出多尺度上下文翻译策略MSCTS,以提升模型在给定不同范围前文的情况下的上下文知识提取能力。本文工作在语音到文本翻译数据集MuST-C v1.0的六个方向上进行实验,实验结果表明本文所提出的方法超过强基线模型和以往工作。此外,本文方法在同音字翻译准确率上也有提升。

2. An Explicit Multi-modal Fusion Method for Sign Language Translation

作者:Cong Hu, Biao Fu, Pei Yu, Liang Zhang, Xiaodong Shi, Yidong Chen

本文由我实验室2021级硕士生胡聪同学,2023级博士生付彪同学,2021级硕士生余培同学,陈毅东教授(通讯作者),史晓东教授,厦门大学数字媒体计算中心2023级博士生张亮同学合作完成。

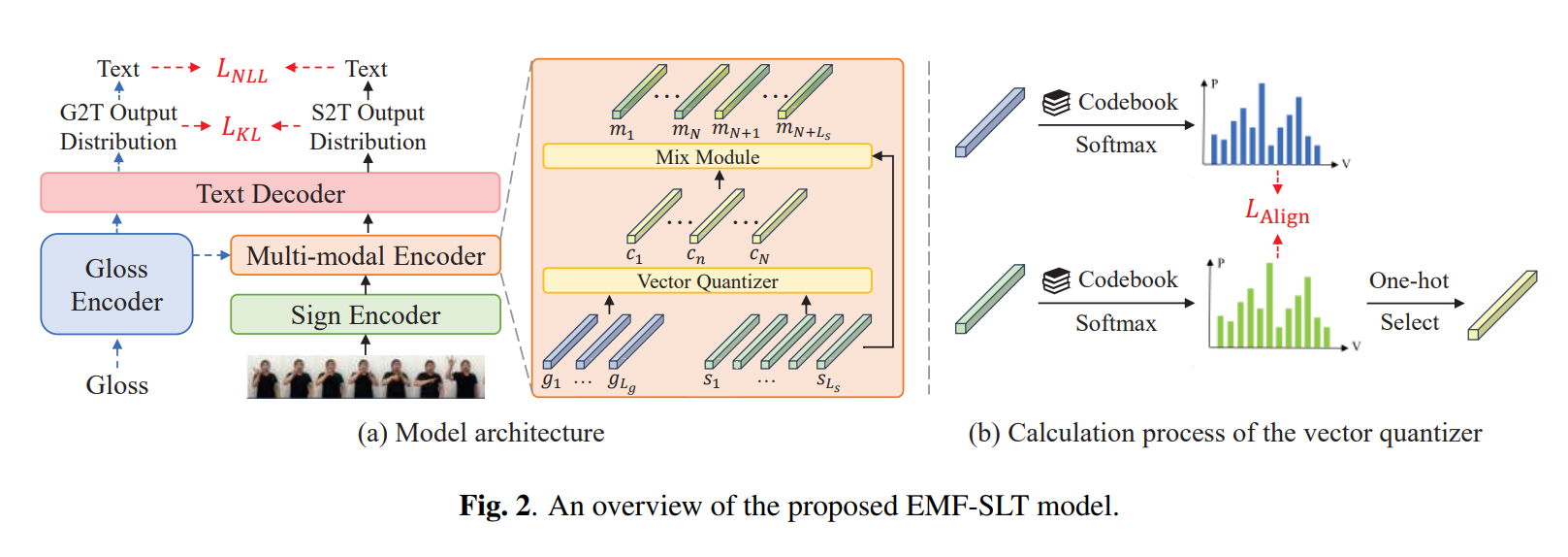

手语翻译(Sign Language Translation, SLT)是一项跨模态任务,其目标是将手语视频转化为口语文本,以便听障人士更轻松地与非手语使用者进行沟通。目前,现有研究主要集中在如何训练统一的端到端模型上。然而,手语和口语文本之间存在固有的模态差距限制了端到端SLT模型的效果。现有的解决方案通常引入注解文本(Gloss)作为中间监督信号,试图通过多任务方式隐式地融合不同的模态,在SLT任务中取得了一定的改进。然而,这些研究往往忽视了注解文本与口语文本之间的语言一致性,比如它们之间词汇的高重合度,导致未能有效地弥合模态差距。因此,我们提出了一种显式多模态融合手语翻译方法(EMF-SLT),旨在缓解手语和口语文本之间的模态差距。具体而言,EMF-SLT在编码器端利用向量量化和融合模块,预先显示地融合了手语特征和注解文本特征。此外,在解码器端,EMF-SLT采用相互学习训练范式,以促进不同模态输入之间的知识交互,从而提高性能。在CSL-Daily和PHOENIX14T两个数据集上进行的实验证明了我们方法的有效性。此外,本文在消融实验中也验证了EMF-SLT可以有效地弥补模态之间的表征差距,从而提高SLT的性能。